共计 919 个字符,预计需要花费 3 分钟才能阅读完成。

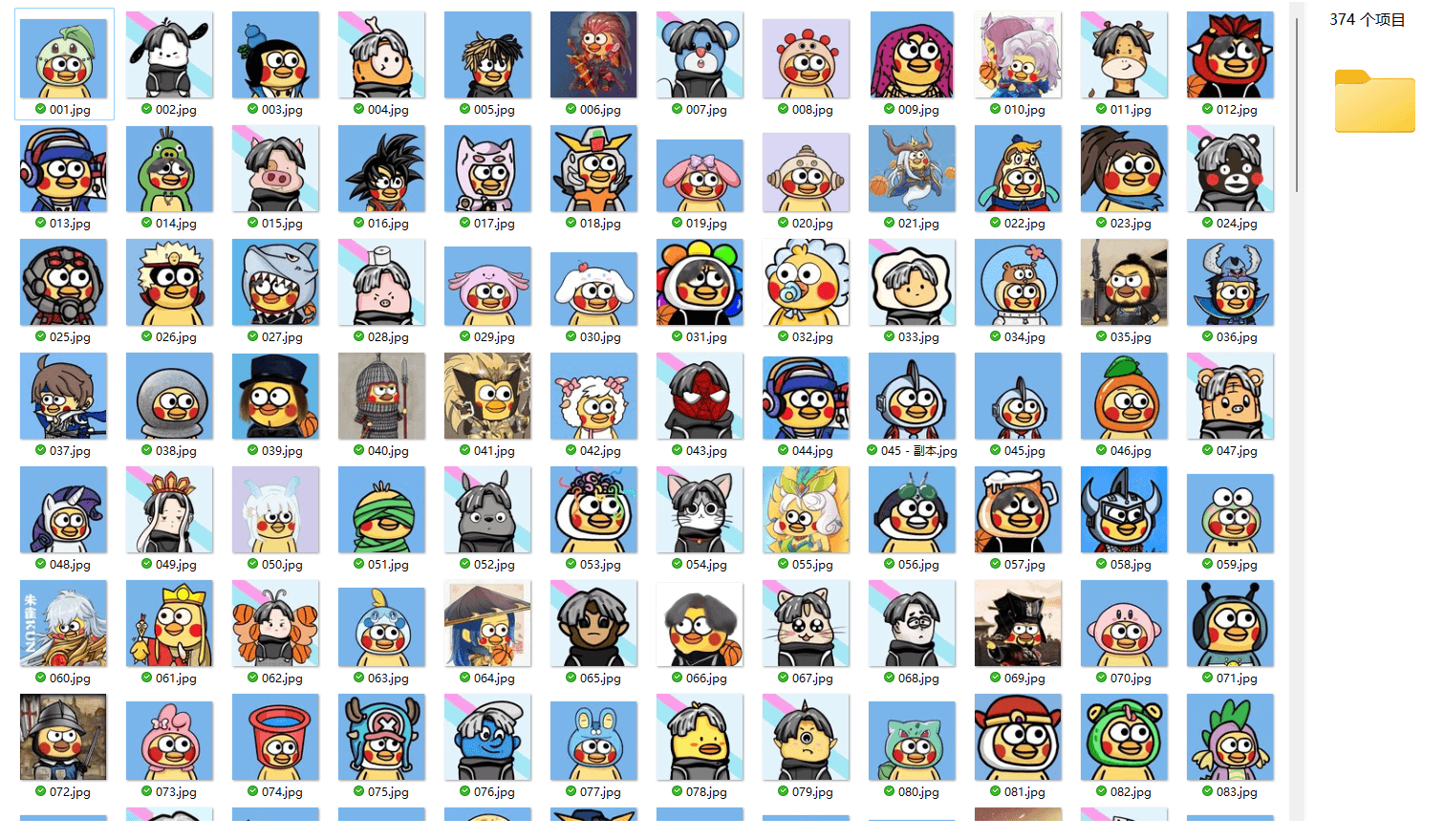

之前看见别人分享小黄鸡头像,但是好像没有提供云盘下载。于是就让 gpt 生成了一下爬取特定页面的代码,爬取后重命名了一下,可以评论获取压缩包。

同时分享下代码,万一下次用得着呢。

import requests

from bs4 import BeautifulSoup

import os

from urllib.parse import urljoin

# 目标页面

url = "https://zhuanlan.zhihu.com/p/578390498"

# 发送HTTP请求获取页面源码

response = requests.get(url)

html = response.text

soup = BeautifulSoup(html, 'html.parser')

# 提取所有图片链接

img_links = [img['src'] for img in soup.find_all('img', {'src': True})]

if not os.path.exists('images'):

os.makedirs('images')

# 下载图片

for img_link in img_links:

# 使用urljoin确保链接是绝对路径

img_url = urljoin(url, img_link)

# 检查链接是否以"http"或"https"开头

if img_url.startswith(('http:', 'https:')):

# 获取图片内容

img_data = requests.get(img_url).content

# 提取图片文件名

img_name = img_url.split("/")[-1]

# 保存图片到目录

with open(os.path.join('images', img_name), 'wb') as img_file:

img_file.write(img_data)

print(f"Downloaded: {img_name}")

else:

print(f"Skipped: {img_url}")

print("All images downloaded successfully.")下载地址

小黄鸡头像:链接:https://pan.baidu.com/s/16p0TqdD8jRYbAsZM46VFmA?pwd=akak

提醒:本文发布于793天前,文中所关联的信息可能已发生改变,请知悉!

AD:【腾讯云服务器大降价】2核4G 222元/3年 1核2G 38元/年

正文完